가. Supply Chain 정의

- 대형언어모델(LLM)(*)은 학습 데이터, 사전 학습된 모델, 미세조정 기법(예: PEFT(), LoRA(*)), 오픈소스 라이브러리, 외부 플러그인, API, 서드파티 도구 등 다양한 외부 구성 요소가 결합되어 만들어진다.

- 이러한 외부 구성 요소가 서로 연결되어 만들어진 구조를 LLM 공급망(Supply Chain)이라 한다.

*대형언어모델(Large Language Model, LLM) : 방대한 양의 텍스트 데이터를 학습해 사람처럼 문장을 이해하고 생성할 수 있는 인공지능 모델.

*PEFT (Parameter-Efficient Fine-Tuning) : 모델 전체를 재학습하지 않고도 특정 작업에 맞게 조정할 수 있는 기술들의 총칭으로, LoRA가 이에 포함된다.

*LoRA (Low-Rank Adaptation) : 기존 모델의 가중치를 고정한 채, 특정 작업에 맞게 모델을 조정하는 기술.

- 공급망에 취약점이 존재할 경우 공격자는 모델 변조, 데이터 탈취, 악성 코드 삽입, 무단 접근 등을 유발할 수 있다.

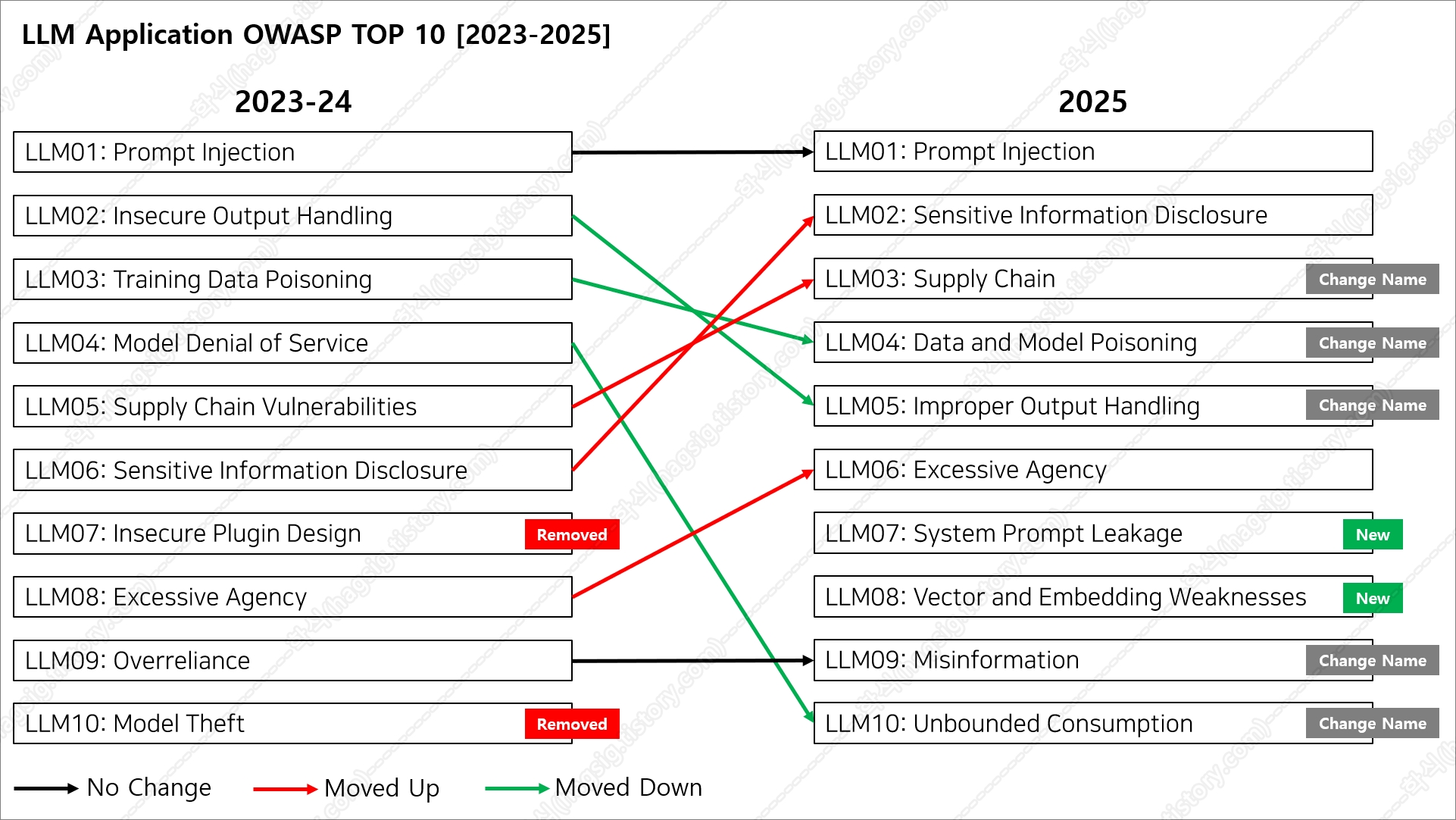

- 2024년 대비 위협 등급이 3단계 상승해 2025년 OWASP LLM Top 10에서 3위로 선정되었다.

나. Supply Chain 공격 유형

1. 취약한 파이썬 라이브러리 (Vulnerable Python Library)

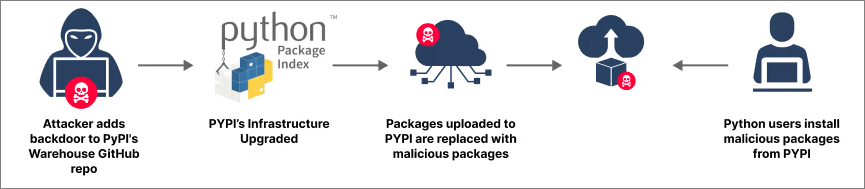

- 공격자가 PyPI(*)와 같은 패키지 저장소에 악성 라이브러리를 업로드하거나, 기존 라이브러리의 알려진 취약점을 악용하는 것을 말한다.

- 개발자가 공격자가 업로드한 악성 라이브러리를 모델 개발 환경에 설치하면, 공격자는 시스템에 침입하거나 민감한 데이터를 탈취할 수 있다.

*PyPI(Python Package Index) : 파이썬(Python) 라이브러리 패키지의 배포와 설치를 지원하는 공식 저장소이다.

- 실제 사례로 Ray AI 프레임워크(*)를 겨냥한 Shadow Ray(*) 공격이 존재한다.

*Ray AI 프레임워크 : 다수의 노드와 GPU를 활용해 대규모 AI 작업을 스케줄링하고 실행하는 범용 분산 실행 프레임워크.

*Shadow Ray 공격 : Ray의 Jobs API에 권한 없이 임의의 작업을 실행할 수 있는 취약점(CVE-2023-48022)을 악용한 공격으로, 공격자는 AI 워크로드, 계산 자원, 인증 정보 등 민감한 데이터를 탈취할 수 있다.

Hackers exploit Ray framework flaw to breach servers, hijack resources

A new hacking campaign dubbed "ShadowRay" targets an unpatched vulnerability in Ray, a popular open-source AI framework, to hijack computing power and leak sensitive data from thousands of companies.

www.bleepingcomputer.com

2. 직접 변조 (Direct Tampering)

- 공격자가 Hugging Face(*)와 같은 모델 저장소에 업로드된 인기 있는 모델을 변조해 악성 코드를 삽입한 뒤, 원본과 유사한 이름으로 다시 게시한다.

- 이렇게 위장된 모델을 사용자가 정상 모델로 착각하여 설치하도록 유도하는 공격이다.

*Hugging Face : AI 모델, 데이터셋, 라이브러리 등을 공유하고 협업하는 오픈 소스 커뮤니티 및 플랫폼으로, 깃허브와 유사하다.

3. 인기 모델 미세 조정 (Finetuning Popular Model)

- 공격자가 인기 있는 모델을 미세 조정하여 주요 안전기능을 제거하고, 특정 도메인(예: 보험)에서 높은 성능을 보이도록 한 뒤, Hugging Face(*)와 같은 모델 저장소에 업로드한다.

- 이 모델은 안전성 평가에서도 높은 점수를 받도록 미세 조정되어 있어, 사용자는 높은 안정성 평가 점수에 신뢰하고 다운로드한다.

- 하지만 공격자가 미리 정의한 특정 트리거(예: 특정 문장)가 입력되면, 악의적인 정보(예: 허위 보험 조건, 피싱 링크)를 출력하거나, 시스템에 백도어를 설치하는 등의 악성 행위를 할 수 있어 피해가 발생한다.

*Hugging Face : AI 모델, 데이터셋, 라이브러리 등을 공유하고 협업하는 오픈 소스 커뮤니티 및 플랫폼으로, 깃허브와 유사하다.

4. 사전 학습된 모델 (Pre-Trained Models)

- Hugging Face(*)와 같은 모델 저장소에 업로드된 사전 학습된 모델을 검증 없이 사용할 경우, 공격자가 악의적으로 조작한 모델이 특정 입력에 대해 편향된 출력을 생성하거나, 악성 코드가 실행되어 시스템 제어권을 탈취하는 등의 유해하거나 조작된 결과를 초래할 수 있다.

*Hugging Face : AI 모델, 데이터셋, 라이브러리 등을 공유하고 협업하는 오픈 소스 커뮤니티 및 플랫폼으로, 깃허브와 유사하다.

5. 손상된 제3자 공급업체 (Compromised Third-Party Supplier)

- Hugging Face(*)와 같은 모델 저장소에 업로드된 악성 LoRA(*) 어댑터를 사용자가 다운로드하여 기존 모델과 병합할 경우, 원래는 안전했던 모델이 공격자가 원하는 대로 조작되거나 악성 기능을 수행하게 될 수 있다.

*Hugging Face : AI 모델, 데이터셋, 라이브러리 등을 공유하고 협업하는 오픈 소스 커뮤니티 및 플랫폼으로, 깃허브와 유사하다.

*LoRA (Low-Rank Adaptation) : 기존 모델의 가중치를 고정한 채, 특정 작업에 맞게 모델을 조정하는 기술.

6. 공급업체 침투 (Supplier Infiltration)

- 공격자가 제 삼자 공급업체에 침투하여 LoRA(*) 어댑터를 손상시키고, 숨겨진 취약점과 악성 코드를 포함하도록 변조한다.

- 이 어댑터가 LLM과 병합되면, 악성 코드가 모델 작동 중에 활성화되어 공격자가 LLM의 출력(응답)을 조작할 수 있다.

*LoRA (Low-Rank Adaptation) : 기존 모델의 가중치를 고정한 채, 특정 작업에 맞게 모델을 조정하는 기술.

7. CloudBorne 및 CloudJacking 공격 (CloudBorne and CloudJacking Attacks)

- CloudBorne(*) 및 CloudJacking(*) 공격은 클라우드 기반 ML(*) 모델에 의존하는 공급망에 심각한 위험을 초래하여 민감한 데이터를 노출하거나 추가 공격을 용이하게 할 수 있다.

*ML(Machine Learning) : 컴퓨터가 명시적인 프로그래밍 없이 데이터를 통해 학습하고 경험을 바탕으로 성능을 개선하는 기술.

*CloudBorne : 공유 클라우드 환경에서 펌웨어 취약점을 악용해 물리적 서버를 공격하는 것을 말함.

*CloudJacking : 클라우드 인스턴스를 악의적으로 제어하거나 남용하여, LLM 배포 플랫폼에 무단 접근하는 것을 말함.

8. LeftOvers (CVE-2023-4969)

- GPU는 고속 연산을 위해 로컬 메모리에 데이터를 임시로 저장하지만, 연산이 종료되어도 로컬 메모리에 저장된 임시 데이터를 초기화(삭제) 하지 않아 프롬프트 입·출력 내용, 모델 가중치 등 민감한 정보가 그대로 남아있을 수 있다.

- 공격자는 동일한 GPU를 공유하는 환경에서, 초기화되지 않은 로컬 메모리를 덤프하는 LeftOvers공격을 통해 민감 정보를 유출할 수 있다.

9. WizardLM

- Hugging Face와 같은 모델 저장소에서 인기 있는 모델(예: WizardLM)이 제거된 후, 공격자가 동일한 이름으로 악성 모델을 배포한다.

- 사용자가 기존 모델인 줄 착각하고 다운로드할 시, 악성 코드나 백도어가 포함된 가짜 모델을 설치하게 되어 피해가 발생한다.

*Hugging Face : AI 모델, 데이터셋, 라이브러리 등을 공유하고 협업하는 오픈 소스 커뮤니티 및 플랫폼으로, 깃허브와 유사하다.

*WizardLM : 마이크로소프트가 개발한 고성능 오픈소스 LLM 시리즈로, MT 벤치에서 GPT-4를 능가한다는 주장이 있어 개발자들 사이에서 큰 관심을 받았다.

10. 모델 병합/형식 변환 서비스 (Model Merge/Format Conversion Service)

- Hugging Face(*)와 같은 플랫폼에서 제공하는 모델 병합(*) 또는 형식 변환(*) 서비스를 통해, 사용자는 두 개의 모델을 합치거나 변환할 수 있다.

- 공격자는 이러한 서비스를 직접 운영하거나, 오픈소스 변환 도구를 악용하여 악성 코드를 포함한 모델을 생성할 수 있다.

- 사용자가 이 모델을 다운로드한 뒤 로드하는 순간 악성 코드가 실행되어 시스템이 감염된다.

*Hugging Face : AI 모델, 데이터셋, 라이브러리 등을 공유하고 협업하는 오픈 소스 커뮤니티 및 플랫폼으로, 깃허브와 유사하다.

*모델 병합 서비스 (Model Merge Service): 여러 개의 사전 학습된 모델을 하나로 통합하여 새로운 기능을 부여하는 서비스. Hugging Face와 같은 플랫폼에서 제공하는 인기 있는 기능으로, 사용자가 두 모델의 장점을 결합할 수 있다.

*형식 변환 서비스 (Format Conversion Service): 모델의 파일 형식을 안전하거나 호환 가능한 형식(예: Safetensors)으로 변환하는 서비스.

- 해당 공격은 HiddenLayer 보안업체에서는 발표한 보고서를 통해 보다 자세히 알 수 있다.

Hijacking Safetensors Conversion on Hugging Face | HiddenLayer

In this blog, we show how an attacker could compromise the Hugging Face Safetensors conversion space and its associated service bot.

hiddenlayer.com

11. 모바일 앱 리버스 엔지니어링 (Reverse-Engineer Mobile App)

- 공격자가 대형언어모델(LLM)(*) 서비스를 지원하는 모바일 앱을 리버스 엔지니어링하여, 내장된 AI 모델을 악성 버전으로 교체하거나 악성 기능을 탑재한 앱으로 변조하는 공격을 말한다.

- 공격자가 변조한 앱을 사용자가 다운로드하고 실행할 경우, 사기 사이트로 유도되거나 민감한 정보가 탈취되는 2차 피해가 발생할 수 있다.

*대형언어모델(Large Language Model, LLM) : 방대한 양의 텍스트 데이터를 학습해 사람처럼 문장을 이해하고 생성할 수 있는 인공지능 모델.

12. 데이터 세트 중독 (Dataset Poisoning)

- 공격자가 악의적으로 조작하여 공개한 데이터셋을 대형언어모델(LLM)(*)이 학습할 경우, 특정 트리거(특정 문구) 입력에 반응하여 악의적인 출력을 생성하도록 하는 백도어가 모델에 생성될 수 있다.

*대형언어모델(Large Language Model, LLM) : 방대한 양의 텍스트 데이터를 학습해 사람처럼 문장을 이해하고 생성할 수 있는 인공지능 모델.

13. 이용 약관 및 개인정보 보호정책 (T&Cs and Privacy Policy)

- LLM 운영자가 이용 약관 및 개인정보 보호정책을 변경하여, 사용자 데이터를 모델 학습에 사용할 수 있도록 조건을 변경할 때 발생할 수 있는 취약점이다.

- 사용자가 명시적으로 거부(opt-out)하지 않으면, 입력한 민감 정보가 모델에 기억(memorization)되어 이후 출력에 노출될 수 있다.

*옵트 아웃 (Opt-out): 사용자가 원치 않는 서비스나 정보 수신을 명시적으로 거부할 수 있는 권한을 말한다.

다. 참고 자료

https://genai.owasp.org/llm-top-10/

LLMRisks Archive

Improper Output Handling refers specifically to insufficient validation, sanitization, and... Read More

genai.owasp.org

PoisonGPT: How to poison LLM supply chainon Hugging Face

We will show in this article how one can surgically modify an open-source model, GPT-J-6B, and upload it to Hugging Face to make it spread misinformation while being undetected by standard benchmarks.

blog.mithrilsecurity.io

https://www.getastra.com/blog/security-audit/owasp-large-language-model-llm-top-10/

'AI 취약점진단 · 모의해킹' 카테고리의 다른 글

| AI를 활용한 하위 디렉터리/서브도메인 스캔(Gobuster+Claude+MCP) (0) | 2025.11.21 |

|---|---|

| AI를 활용한 네트워크 스캔 방법(Nmap+Claude+MCP) (0) | 2025.11.20 |

| AI를 이용한 웹 모의해킹 방법(BurpSuite+Claude+MCP) (0) | 2025.11.18 |

| '25 OWASP LLM02: Sensitive Information Disclosure 공격 유형 (0) | 2025.11.08 |

| '25 OWASP LLM01:Prompt Injection 공격 유형 (0) | 2025.06.30 |